- メーカー

- エルザジャパン

- 型番

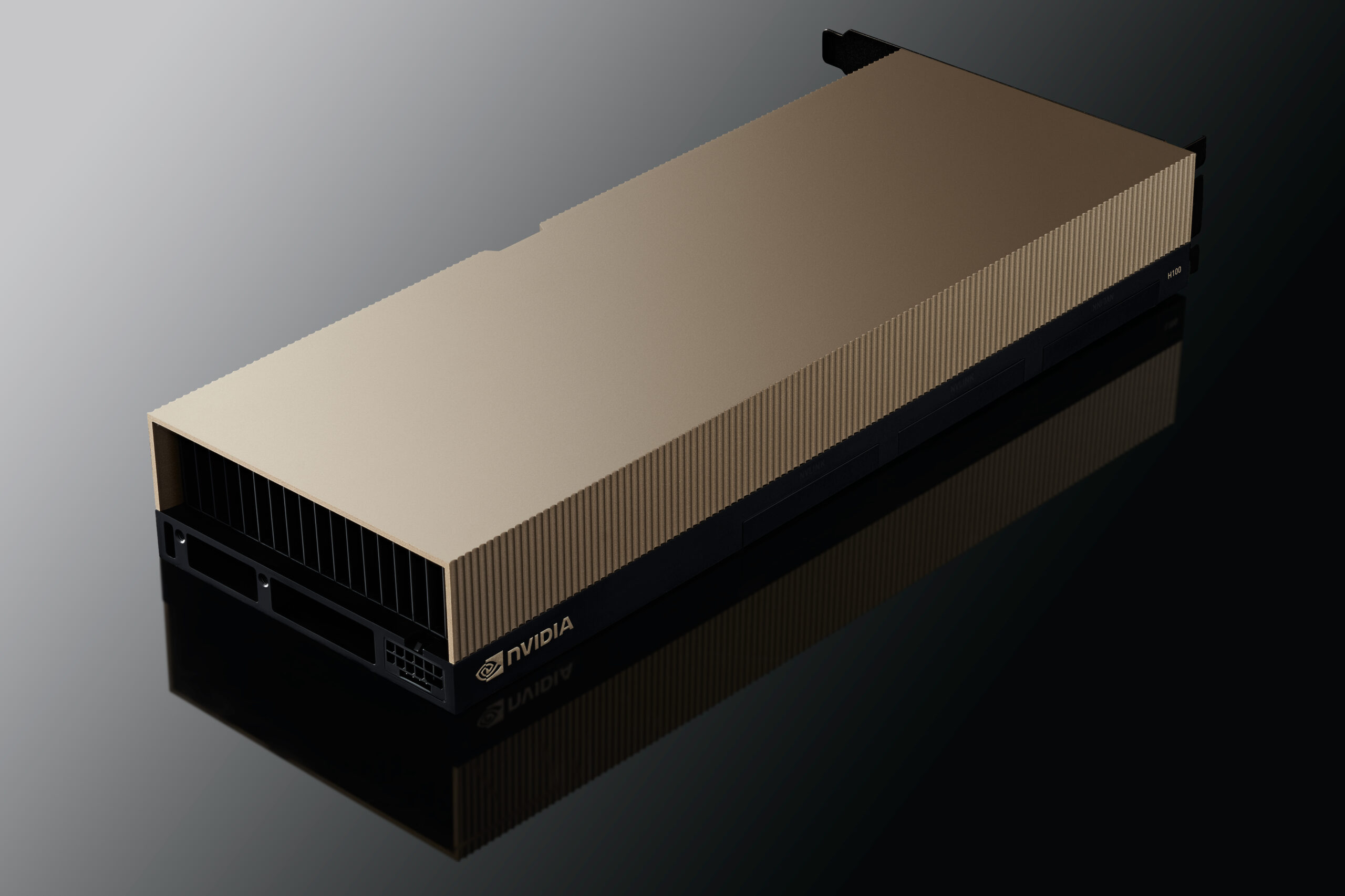

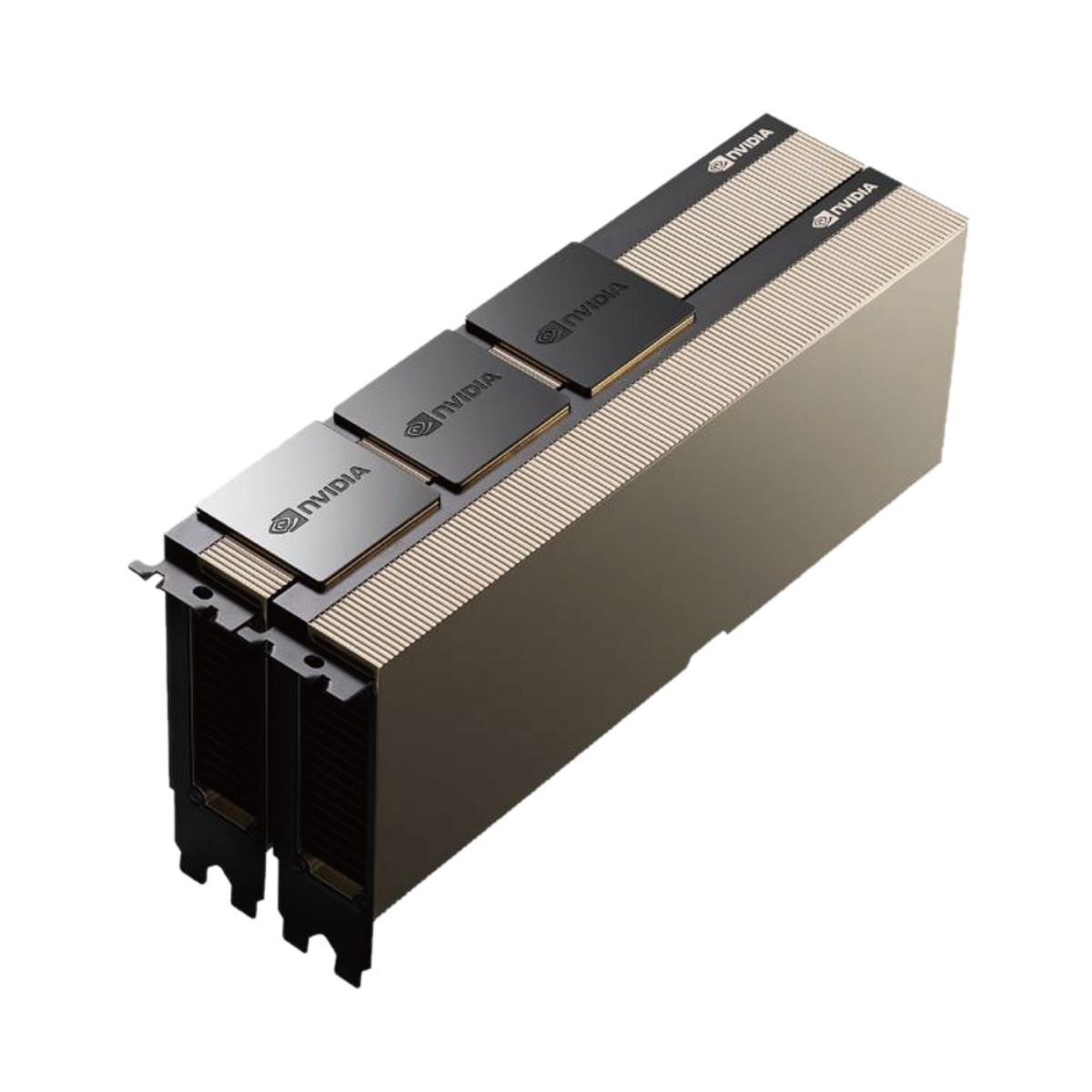

- NVIDIA H100 NVL 94GB

アクセラレーテッド コンピューティングの大きな飛躍

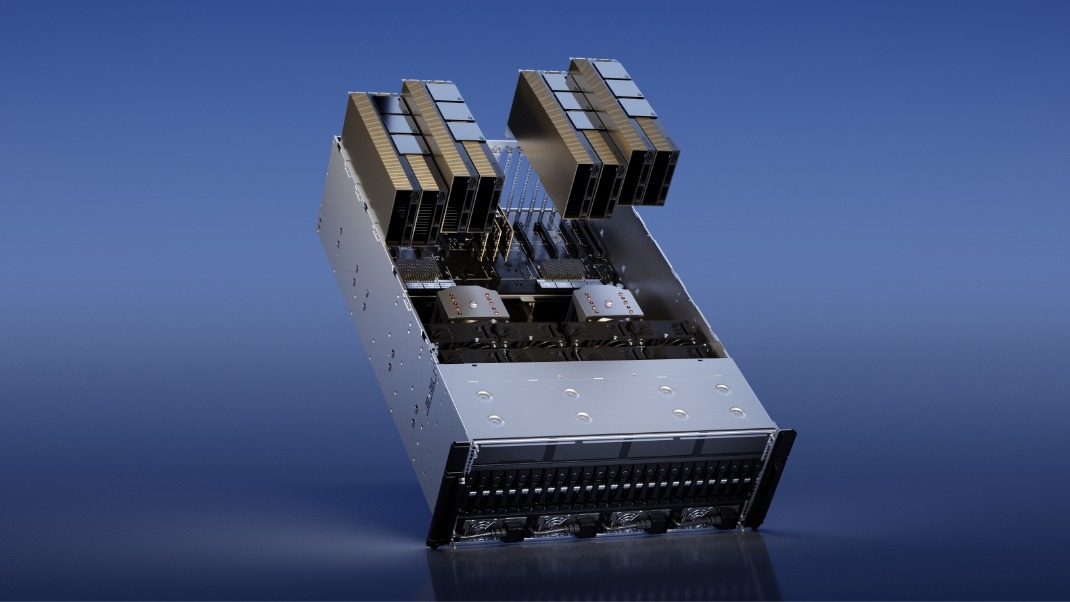

NVIDIA H100 Tensor コア GPUで、あらゆるワークロードのためのかつてない性能、拡張性、セキュリティを手に入れましょう。NVIDIA® NVLink® Switch System により、最大 256 個の H100 を接続し、エクサスケールのワークロードを高速化できます。さらに、専用の Transformer Engine を利用することで、パラメーターが兆単位の言語モデルを実装できます。H100 の複合的な技術革新により、大規模な言語モデルが前世代と比較して 30 倍も高速化され、業界の一歩先を行く対話型 AI が可能となります。

大規模言語モデル推論を加速

最大 1750億 パラメーターの大規模言語モデル (LLM) の場合、PCIe ベースの H100 NVL with NVLink ブリッジ(※)は、Transformer Engine、NVLink、および 188GB HBM3 メモリを利用して、あらゆるデータ センターで最適な性能と容易な拡張性を提供し、LLM を主流にしています。H100 NVL GPU を搭載したサーバーは、電力制約のあるデータ センター環境において低遅延を維持しながら、GPT-175B モデルの性能を NVIDIA DGX™ A100 システムの最大 12 倍まで向上します。※2枚のH100 NVL 94GBを3個のNVLinkブリッジで接続した場合

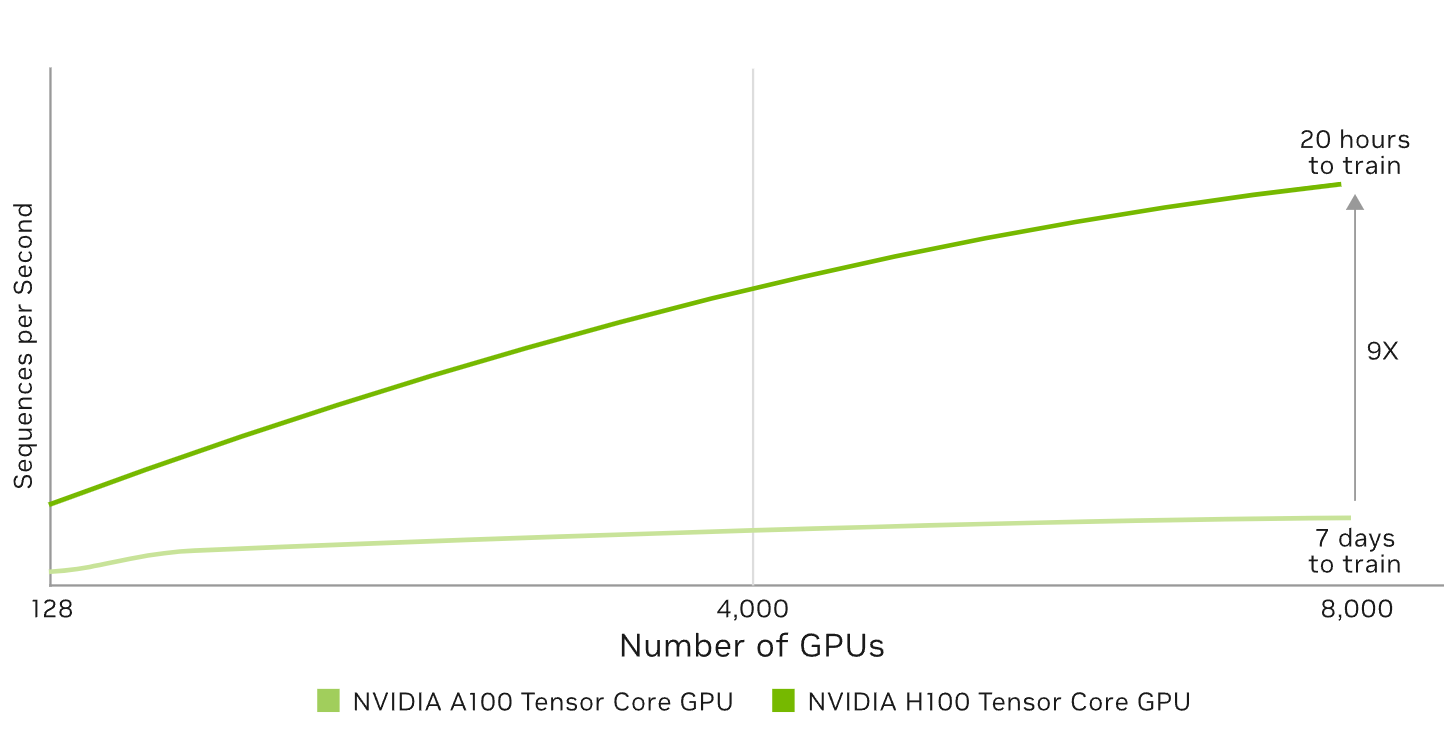

最大規模のモデルでAI トレーニング性能を 最大 9 倍に

混合エキスパート (3950 億個のパラメーター)

予想されるパフォーマンスは変更される可能性があります。Training Mixture of Experts (MoE) Transformer Switch-XXL バリアントと 1T トークン データセット上の 395B パラメーター | A100 クラスター: HDR IB ネットワーク | H100 クラスター: NVLINK スイッチ システム、NDR IB

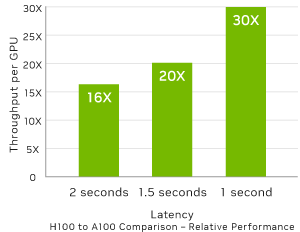

最大規模のモデルで AI 推論性能を最大 30 倍に

Megatron チャットボット推論 (5300 億個のパラメーター) Projected performance subject to change. Inference on Megatron 530B parameter model chatbot for input sequence length=128, output sequence length=20 | A100 クラスター:HDR IB ネットワーク | H100 クラスター: 16 個の H100 構成のための NDR IB ネットワーク | 1 秒と 1.5 秒の場合の 32 A100 と 16 H100 の比較 | 2 秒の場合の 16 A100 と 8 H100 の比較

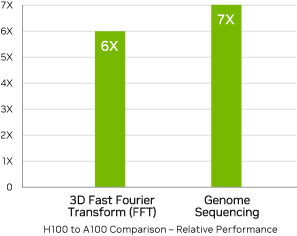

HPCアプリケーションのパフォーマンスが 最大 7 倍に

予想されるパフォーマンスは変更される可能性があります。3D FFT (4K^3) スループット | A100 クラスター: HDR IB ネットワーク | H100 クラスター: NVLink スイッチ システム、NDR IB | ゲノム シーケンシング (Smith-Waterman) | 1 A100 | 1 H100

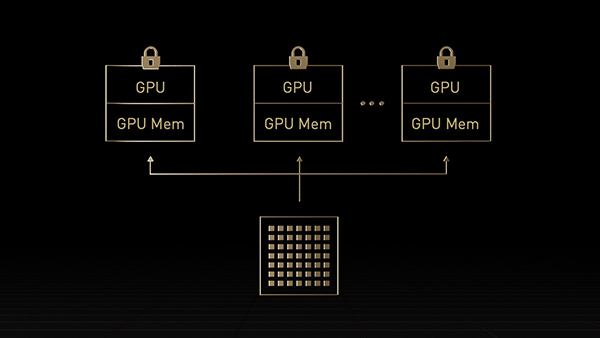

企業で効率的に利用

H100 の第 2 世代 マルチ インスタンス GPU (MIG) では、7 個ものインスタンスに分割することで各 GPU の利用率を最大化します。コンフィデンシャル コンピューティング対応のH100では、マルチテナントをエンドツーエンドで安全に利用できます。クラウド サービス プロバイダー (CSP) 環境に最適です。

お問い合わせ